linux下使用virsh批量关闭或开启KVM虚拟机

批量关闭(软关机)for i in $(virsh list --name --autostart); do virsh shutdown $i; done批量关闭(硬关机)for i in $(virsh list --name --autostart); do virsh destroy $i; done批量开启for i ……

Linux下rsync使用实例:增量同步|单向覆盖|仅更新

前言如果手上经常有大量数据需要跨服务器转移,那么rsync真的是个好东西!功能非常的丰富,这里记录一下自己实际使用的案例,不定期增加内容和更新。inplace参数:实现块文件/镜像文件增量备份与复制简而言之就是:1. rsync默认情况下是将更新的文件复制到目标路径后替换旧文件default method of creating a new cop……

Ceph集群在线修改存储池pool的CrushRule规则|备份数size|最小备份数min_size

没啥好说的,就是修改Ceph集群里存储池pool的CrushRule规则、备份数size和最小备份数min_size修改CrushRule:ceph osd pool set [存储池名] crush_rule [CrushRule规则名]修改默认备份数:ceph osd pool set [存储池名] size [份数]修改最小备份数(低于这个就停止……

Ceph集群设置crush rule指定osd类型(区分ssd固态硬盘和hdd机械硬盘)

官方的帮助文档中描述是:ceph crush rule create-replicated default 建立纯ssd的crush规则: ceph osd crush rule create-replicated ssd-pool default host ssd建立纯ssd的crush规则: ceph osd crush rule……

Ceph集群存储在分区中新建OSD

如果是全新新建的话,直接用这个就行了:sudo ceph-volume lvm create --data /dev/sda3 --crush-device-class ssd记得用fdisk进行分区,例子中是sda3作为osd的分区,ssd是crush中的磁盘类型如果因为连接cluster失败的话,先初始化pveceph init,并更新ke……

Nginx中rewrite改写url并替换其中的字符

前言由于某个API的特殊需求,在url中会出现两次?,例如:https://api.cloudraft.cn/?https://api.cloudflare.com/client/v4/zones/03bfeae5bfad300000000563011154cb/dns_records?&per_page=10&page=1这种时候……

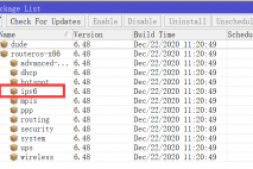

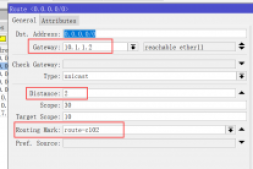

RouterOS CHR开启DHCPv6自动分配IPv6地址

前言继续配置RouterOS,这次是开启IPv6下发和转发功能,由于之前在Windows Server下的种种尝试,这次没有到处找教程啥的,直接上手配置就搞定了。这里分享一下过程吧~开启IPv6功能首先开启IPv6模块,这个我找了半天才发现默认是关闭的...在System>Packages里,找到IPv6,开启这个插件。开启后是不会立刻生效的……

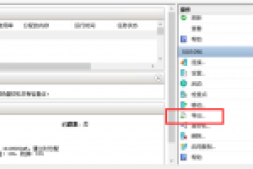

将虚拟机从Hyper-V转移到KVM|导出完整vhdx磁盘转换qcow2

前言HyperV虚拟机有一些独特的好处,例如重复数据删除、windows系统性能加成、图形化管理等等,但是一来授权价格昂贵,二来扩展和批量操作不易,所以这边打算转移一批hyperv虚拟机到kvm(proxmox)下,这里记录一下操作流程。导出vhdx磁盘这里务必要注意,首先彻底关闭要迁移的虚拟机,等彻底关闭后,选择【导出】之所以不直接磁盘文件而是……

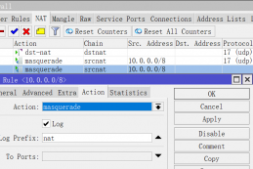

RouterOS CHR设置防火墙log日志规则 记录所有非DNS的连接请求

前言由于监管需要以及对abuse的取证需求,需要记录下用户所有的连接请求,以备不时之需。RouterOS配置设置日志首先在IP>Firewall>NAT中,选择已有的masquerade规则(只选择需要记录的规则,其他的如DNS之类的可以排除在外),在action中勾选log,并设置prefix前缀为nat然后在System>Logging>A……

MikroTik RouterOS CHR设置PCC多线分流

前言目前芬兰的万兆交换机上联还是1G的公网,所以下载需求高的时候有点吃紧。如果要换到上联10G的话机房那边说要按流量计费,对于我们目前每月几百T的流量来说价格较高并不划算。而每台物理机本身就附赠了1G的上联带宽,同时不计流量,所以考虑通过万兆内网将每台机器的千兆公网进行负载均衡。之前尝试了爱快的方案,配置很简单,多WAN配置后开启多线负载即可,根据流量……